WZ-IT Blog

Insights, Tutorials und Best Practices aus der Welt von Cloud, DevOps und Open Source

KI

Upgrade-Announcement: Unsere Cloud GPU Server laufen jetzt auf NVIDIA RTX 6000 Blackwell

Ab sofort setzen wir in unserem AI Server Pro nicht mehr auf die RTX 6000 Ada, sondern auf die NVIDIA RTX 6000 Blackwell Max-Q. Damit...

Paperless-AI installieren (Linux) – One-Liner Installer-Skript mit Docker & Caddy HTTPS

Paperless-AI ist eine KI-Erweiterung für Paperless-ngx, die eingehende Dokumente automatisch analysiert und mit passenden Tags versieht. Egal ob OpenAI, lokale Modelle mit Ollama oder Azure...

Open WebUI installieren (Linux) – One-Liner Installer-Skript mit Docker & Caddy HTTPS

Open WebUI ist eine mächtige selbst gehostete Web-Oberfläche für Large Language Models. Egal ob lokale Modelle mit Ollama oder Anbindung an OpenAI - Open WebUI...

GPT-OSS 120B auf dem AI Cube Pro: OpenAIs Open-Source-Modell lokal betreiben

Mit GPT-OSS 120B hat OpenAI im August 2025 erstmals seit GPT-2 wieder ein Open-Weight-Modell veröffentlicht – und es ist beeindruckend. Das Modell erreicht nahezu die...

Lokale KI-Inferenz mit unserem AI Cube: Ihre KI-Infrastruktur in Eigenregie

In Zeiten von steigenden Cloud-Kosten, Datenhoheit-Herausforderungen und Vendor-Lock-in wird das Thema Lokale KI-Inferenz für Unternehmen immer zentraler. Mit dem AI Cube von WZ-IT setzen Sie...

Ollama vs. vLLM – Der Vergleich für Self-Hosted LLMs im Unternehmenseinsatz

Immer mehr Unternehmen denken darüber nach, Large Language Models (LLMs) nicht mehr über Cloud-APIs, sondern auf eigener Hardware zu betreiben. Gründe dafür sind Datenschutz, Kostenkontrolle...

Lassen Sie uns über Ihre Idee sprechen

Ob konkrete IT-Herausforderung oder einfach eine Idee – wir freuen uns auf den Austausch. In einem kurzen Gespräch prüfen wir gemeinsam, ob und wie Ihr Projekt zu WZ-IT passt.

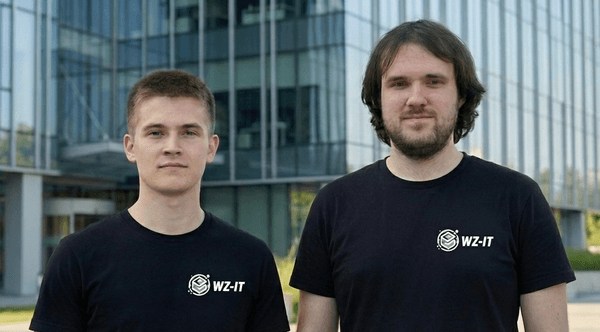

Timo Wevelsiep & Robin Zins

Geschäftsführer