GPU Server für KI sind spezialisierte Hochleistungsserver, die mit NVIDIA RTX Professional GPUs ausgestattet sind. Anders als herkömmliche Server nutzen sie die parallele Rechenarchitektur von Grafikprozessoren, um KI-Modelle bis zu 100x schneller zu trainieren und auszuführen. Besonders für Deep Learning, neuronale Netze und Large Language Models sind GPUs unverzichtbar, da sie Tausende von Berechnungen gleichzeitig durchführen können.

In Deutschland gehostet bedeutet vollständige DSGVO-Konformität, niedrige Latenz und maximale Datensouveränität. Ihre Trainingsdaten und Modelle verlassen nie den deutschen Rechtsraum – ein entscheidender Vorteil für Unternehmen mit sensiblen Daten.

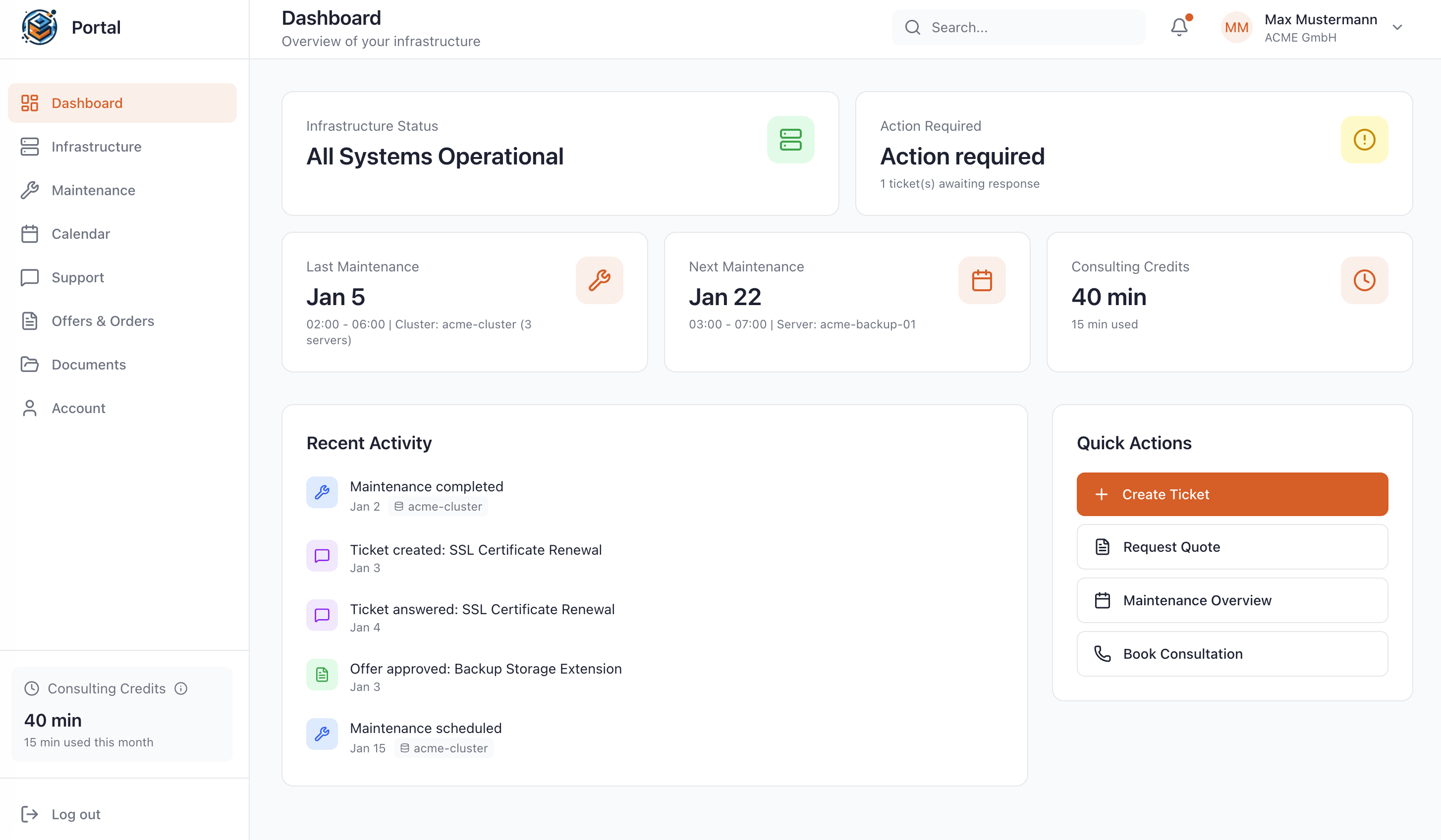

Unsere GPU Server werden als Managed Service angeboten: Wir kümmern uns um Installation, GPU-Treiber-Optimierung, Monitoring und Wartung, während Sie sich auf Ihre KI-Projekte konzentrieren können.