Large Language Models (LLM) sind KI-Modelle, die natürliche Sprache verstehen und generieren können. Für Unternehmen bieten sie enorme Möglichkeiten: von der Automatisierung der Kundenkommunikation über intelligente Dokumentenanalyse bis hin zu Coding-Assistenten und Wissensmanagement.

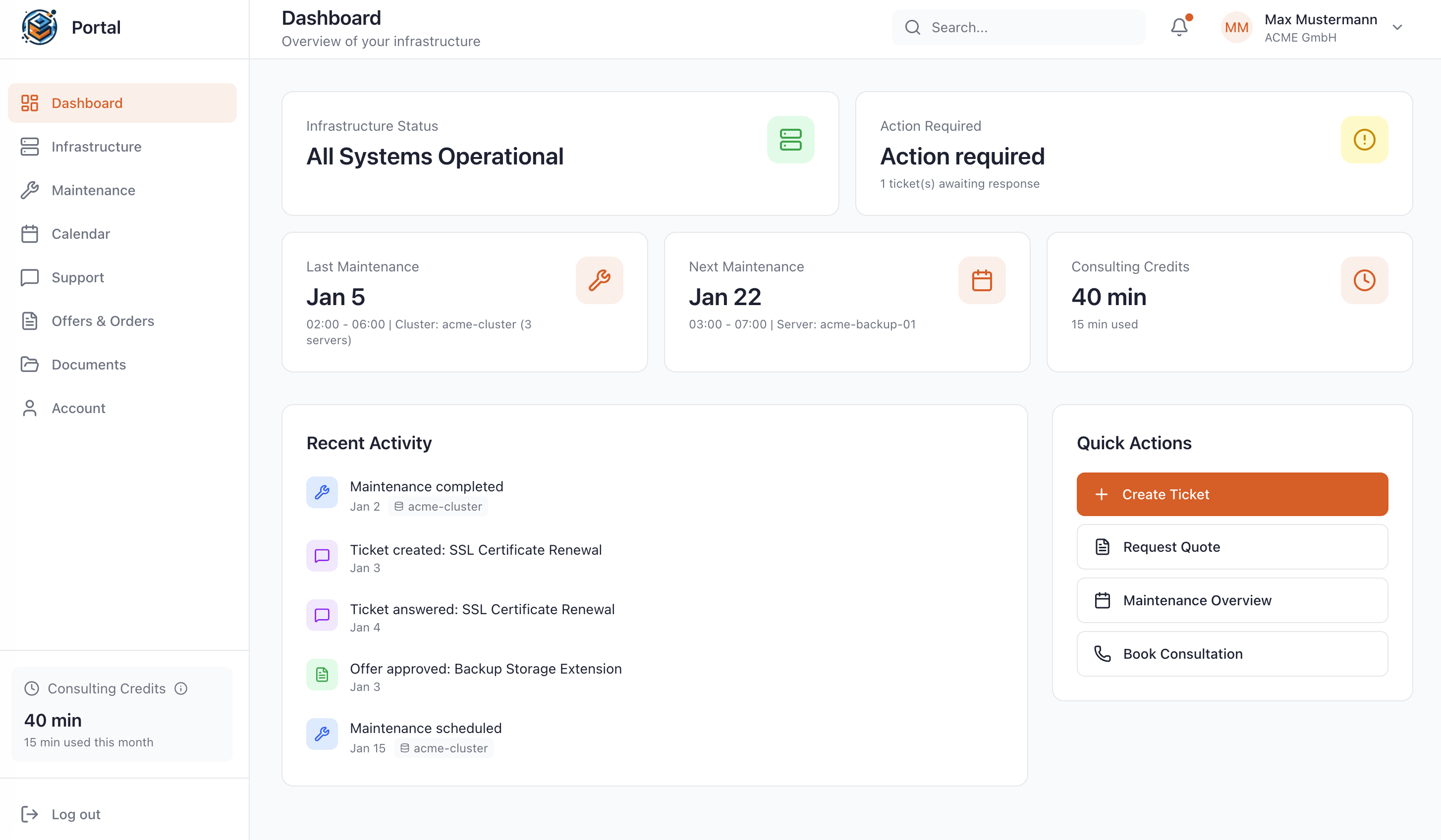

Mit unserem LLM Hosting Deutschland betreiben Sie diese leistungsstarken Modelle in Ihrer eigenen, DSGVO-konformen Infrastruktur – ohne Ihre sensiblen Daten an globale Cloud-Anbieter weitergeben zu müssen.

Ob Llama 3.1, Gemma 3, DeepSeek-R1 oder andere Open-Source-Modelle – wir kümmern uns um Installation, Betrieb und Optimierung Ihrer LLM-Infrastruktur.