Open WebUI installieren (Linux) – One-Liner Installer-Skript mit Docker & Caddy HTTPS

Professionelles Open WebUI Hosting oder Installation gesucht? Wir bei WZ-IT übernehmen Beratung, Installation, Support, Betrieb, Wartung und Monitoring von Open WebUI - auf unserer Infrastruktur oder eurer. Kostenlose Beratung vereinbaren: Termin buchen.

Open WebUI ist eine mächtige selbst gehostete Web-Oberfläche für Large Language Models. Egal ob lokale Modelle mit Ollama oder Anbindung an OpenAI - Open WebUI liefert ein ChatGPT-ähnliches Erlebnis auf der eigenen Infrastruktur.

Wir haben ein kostenloses Open-Source Installer-Skript gebaut, das Open WebUI mit Docker in wenigen Minuten deployt - inklusive optionalem HTTPS, GPU-Support und produktionsreifen Defaults.

Inhaltsverzeichnis

- Was dabei ist

- Voraussetzungen

- Option 1: Quick Install (Ein Befehl)

- Option 2: Erst prüfen, dann installieren (Empfohlen)

- So läuft die Installation

- Nach der Installation

- Nützliche Befehle

- LLM-Backends anbinden

- Deinstallation

- Troubleshooting

- Quellcode

Was dabei ist

Unser Installer-Skript bietet:

- Automatische Docker-Installation - Docker und Docker Compose werden bei Bedarf installiert

- Interaktive Konfiguration - Installationsverzeichnis, Domain, GPU-Support und Image-Variante wählen

- Optionales HTTPS - Caddy Reverse Proxy mit automatischen Let's Encrypt Zertifikaten

- GPU-Unterstützung - NVIDIA GPU-Beschleunigung für lokale Inferenz

- Produktionsreifes Setup - Sinnvolle Defaults für sofortigen Einsatz

Voraussetzungen

- Linux-Server (Ubuntu, Debian, CentOS, RHEL, etc.)

bashundcurl(auf den meisten Systemen vorinstalliert)sudo-Rechte für Docker-Installation- Für HTTPS: Domain mit DNS auf den Server

- Für GPU: NVIDIA GPU mit nvidia-docker

Option 1: Quick Install (Ein Befehl)

Wenn ihr der Quelle vertraut, reicht ein Befehl:

curl -fsSL https://raw.githubusercontent.com/wzitcom/public-scripts/main/open-source-apps/open-webui/install.sh | bash

Option 2: Erst prüfen, dann installieren (Empfohlen)

Wer auf Nummer sicher gehen will, lädt das Skript erst runter und schaut rein:

# Installer herunterladen

curl -O https://raw.githubusercontent.com/wzitcom/public-scripts/main/open-source-apps/open-webui/install.sh

# Skript durchschauen

cat install.sh

# Ausführbar machen und starten

chmod +x install.sh

./install.sh

Generell empfehlen wir, Skripte vor der Ausführung zu prüfen - besonders wenn sie mit sudo laufen.

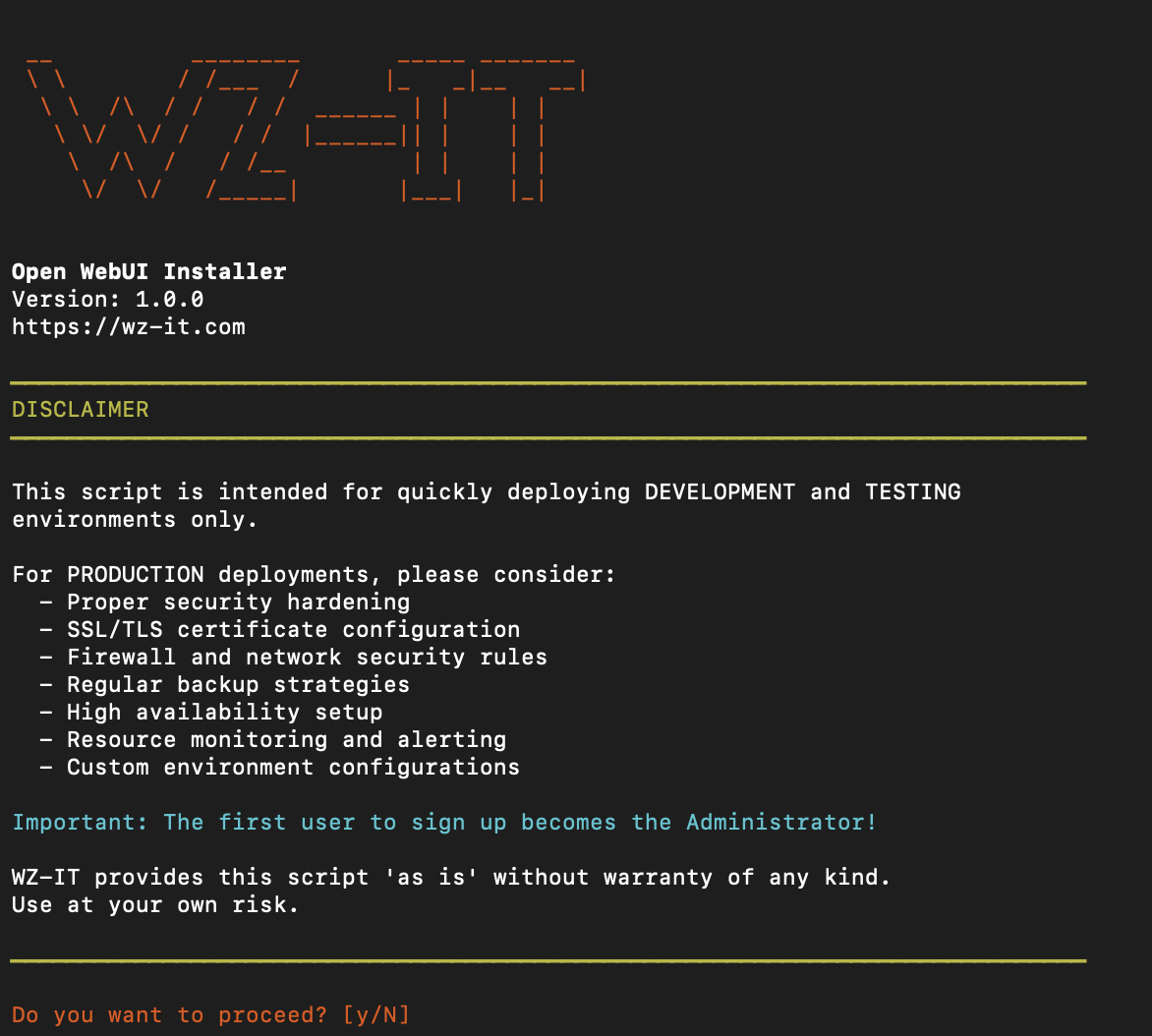

So läuft die Installation

Beim Ausführen des Installers erscheint ein interaktiver Setup:

Das Skript fragt nach:

- Installationsverzeichnis - Wo die Config-Dateien liegen (Default:

~/open-webui) - Domain - Optional für HTTPS-Setup

- GPU-Support - NVIDIA GPU-Beschleunigung aktivieren

- Image-Variante - Volles oder schlankes Docker-Image

Danach passiert automatisch:

- Docker wird bei Bedarf installiert

docker-compose.ymlwird mit den Einstellungen erstellt- Caddy wird für HTTPS eingerichtet (falls Domain angegeben)

- Container werden gestartet

- Zugangsdaten werden angezeigt

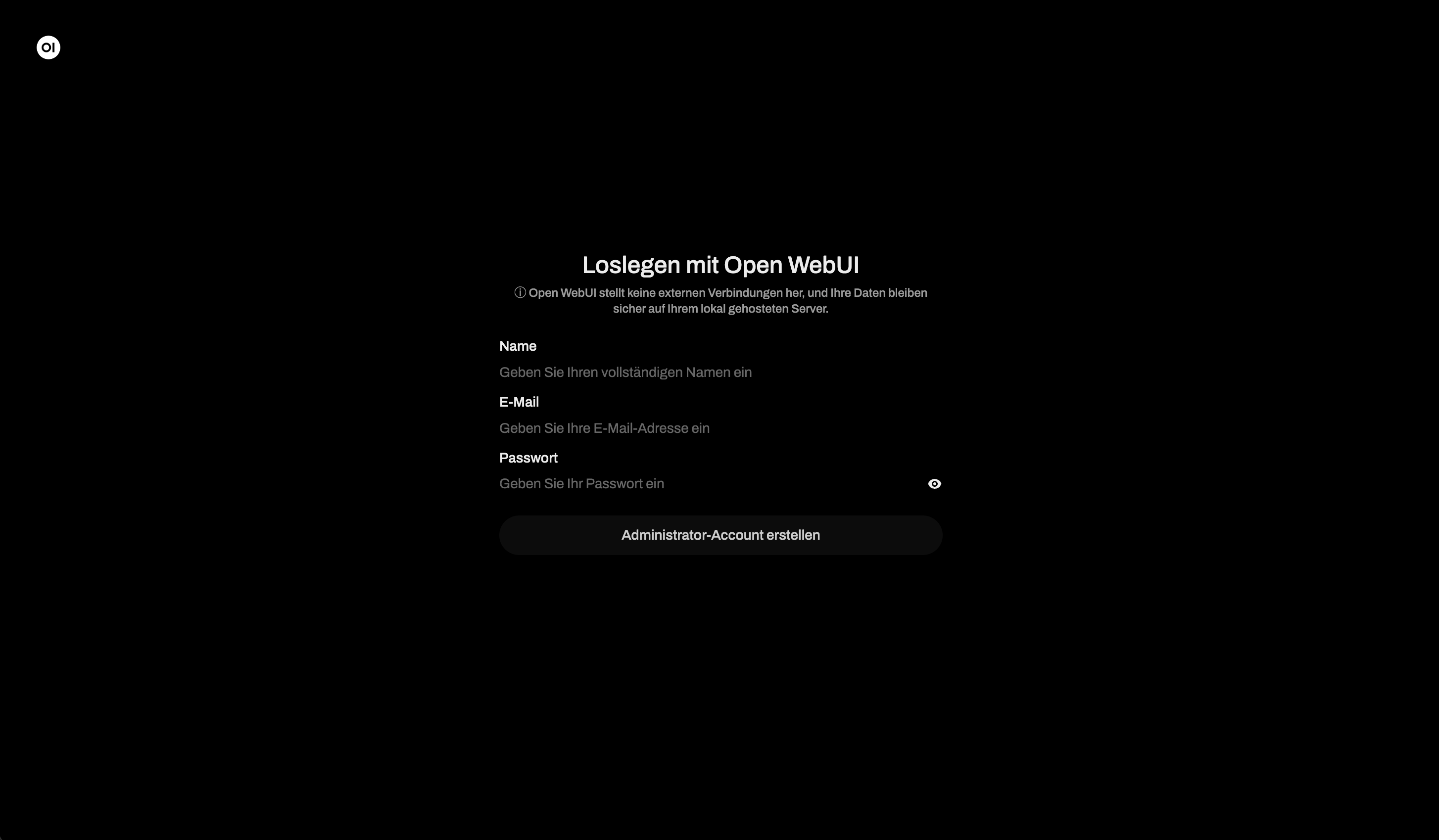

Nach der Installation

Nach Abschluss erscheint der Open WebUI Login:

Erster Login

- Open WebUI aufrufen (http://localhost:3000 oder eure Domain)

- Auf "Sign up" klicken und Account erstellen

- Der erste User wird automatisch Admin

Installationsdateien

Im Installationsverzeichnis liegen:

| Datei | Zweck |

|---|---|

docker-compose.yml |

Docker-Service-Definitionen |

.env |

Umgebungsvariablen und API-Keys |

Caddyfile |

Caddy Reverse Proxy Config (bei Domain-Nutzung) |

Nützliche Befehle

Erst ins Installationsverzeichnis wechseln:

cd ~/open-webui

Service-Verwaltung

# Logs anzeigen

docker compose logs -f

docker compose logs -f open-webui

docker compose logs -f caddy # Bei Caddy

# Services stoppen

docker compose down

# Services starten

docker compose up -d

# Services neustarten

docker compose restart

# Status checken

docker compose ps

Updates

# Neueste Images ziehen und neustarten

docker compose pull

docker compose up -d

LLM-Backends anbinden

Ollama (Lokale Modelle)

Wenn Ollama auf dem gleichen Rechner läuft:

cd ~/open-webui

nano .env

Diese Zeile hinzufügen oder einkommentieren:

OLLAMA_BASE_URL=http://host.docker.internal:11434

Dann neustarten:

docker compose down && docker compose up -d

OpenAI API

In .env den API-Key eintragen:

OPENAI_API_KEY=sk-your-api-key-here

Container neustarten damit die Änderung greift.

Deinstallation

Open WebUI komplett entfernen:

cd ~/open-webui

# Container stoppen und entfernen

docker compose down

# Auch Volumes entfernen (ACHTUNG: löscht alle Daten!)

docker compose down -v

# Installationsverzeichnis löschen

cd ~

rm -rf ~/open-webui

Troubleshooting

Port schon belegt

Wenn Ports 80/443 belegt sind (bei Caddy):

# Schauen was die Ports nutzt

sudo lsof -i :80

sudo lsof -i :443

SSL-Zertifikat-Probleme

# Caddy-Logs checken

docker compose logs caddy

# DNS prüfen

nslookup eure-domain.com

GPU wird nicht erkannt

# nvidia-docker testen

docker run --rm --gpus all nvidia/cuda:11.0-base nvidia-smi

Container startet nicht

# Container-Logs checken

docker compose logs open-webui

# Container-Status anzeigen

docker ps -a

Quellcode

Das Installer-Skript ist Open Source auf GitHub:

- Repository: github.com/wzitcom/public-scripts

- Open WebUI Installer: open-source-apps/open-webui

Gerne reinschauen, forken oder beitragen!

Hinweis

Das Skript ist für schnelles Deployment von Dev- und Test-Umgebungen gedacht.

Für Produktion solltet ihr beachten:

- Security Hardening

- SSL/TLS-Konfiguration

- Firewall- und Netzwerk-Regeln

- Backup-Strategie

- Hochverfügbarkeit

- Monitoring und Alerting

- Angepasste Konfiguration

Produktionsreifes Setup gesucht? Kontaktiert WZ-IT für professionelle Open WebUI Installation und Managed Hosting.

Häufig gestellte Fragen

Antworten auf wichtige Fragen zu diesem Thema

Open WebUI ist eine selbst gehostete Web-Oberfläche für Large Language Models (LLMs). Es unterstützt verschiedene Backends wie Ollama und OpenAI und bietet Benutzerverwaltung, Chat-Verlauf, RAG und mehr.

Der Installer funktioniert auf allen gängigen Linux-Distributionen wie Ubuntu, Debian, CentOS, RHEL, Rocky Linux, AlmaLinux, Fedora und openSUSE - eigentlich auf jedem System mit bash, curl und Docker-Support.

Ja. Falls Docker noch nicht vorhanden ist, installiert das Skript Docker und Docker Compose automatisch.

Ja. Bei Angabe einer Domain konfiguriert das Skript Caddy als Reverse Proxy mit automatischen Let's Encrypt Zertifikaten.

Ja. Der Installer fragt, ob GPU-Support aktiviert werden soll. Bei Auswahl wird der Docker-Container für NVIDIA GPUs konfiguriert.

Nach der Installation die .env-Datei bearbeiten und OLLAMA_BASE_URL auf die Ollama-Instanz setzen (z.B. http://host.docker.internal:11434), dann mit docker compose up -d neustarten.

Der Installer erstellt schnell ein funktionierendes Setup. Für Produktion empfehlen wir zusätzliche Sicherheitshärtung, Backups und Monitoring - das bietet WZ-IT als Managed Service an.

Klar. Wir empfehlen, das Skript erst mit curl -O herunterzuladen und vor der Ausführung durchzuschauen. Der Code ist Open Source und auf GitHub einsehbar.

Geschrieben von

Timo Wevelsiep

Co-Founder & CEO

Co-Founder von WZ-IT. Spezialisiert auf Cloud-Infrastruktur, Open-Source-Plattformen und Managed Services für KMUs und Enterprise-Kunden weltweit.

LinkedInLassen Sie uns über Ihre Idee sprechen

Ob konkrete IT-Herausforderung oder einfach eine Idee – wir freuen uns auf den Austausch. In einem kurzen Gespräch prüfen wir gemeinsam, ob und wie Ihr Projekt zu WZ-IT passt.

Timo Wevelsiep & Robin Zins

Geschäftsführer