Open WebUI vs. AnythingLLM: Der ausführliche Vergleich für selbstgehostete LLM-Interfaces

Die Nutzung von Large Language Models (LLMs) wie GPT-4, Claude oder Llama hat sich in den letzten Jahren von experimentellen Anwendungen zu unternehmenskritischen Werkzeugen entwickelt. Doch während Cloud-basierte Lösungen wie ChatGPT Plus oder Claude Pro einfach zugänglich sind, stellen sie Unternehmen vor erhebliche Herausforderungen: Fehlende Datenkontrolle, unklare Datenverarbeitung in Drittländern und Compliance-Risiken nach DSGVO sind nur einige der Bedenken.

Hier kommen selbstgehostete LLM-Interfaces ins Spiel. Sie ermöglichen es Unternehmen, leistungsstarke KI-Modelle zu nutzen, ohne sensible Daten an externe Anbieter weiterzugeben. Zwei der beliebtesten Open-Source-Lösungen in diesem Bereich sind Open WebUI und AnythingLLM.

In diesem ausführlichen Vergleich analysieren wir beide Plattformen hinsichtlich Installation, Features, RAG-Fähigkeiten (Retrieval-Augmented Generation), Datenschutz und Unternehmenstauglichkeit. Ziel ist es, IT-Entscheidern und Entwicklern eine fundierte Grundlage für die Auswahl der passenden Lösung zu bieten.

Inhaltsverzeichnis

- Kurzüberblick der beiden Tools

- Vergleich der Kernkriterien

- Stärken & Schwächen im Einzelnen

- Passung für den Unternehmenseinsatz / Use-Case Empfehlungen

- Empfehlungen & Fazit

- Ausblick & weiterführende Themen

- Kontaktieren Sie uns

- Quellenverzeichnis

Kurzüberblick der beiden Tools

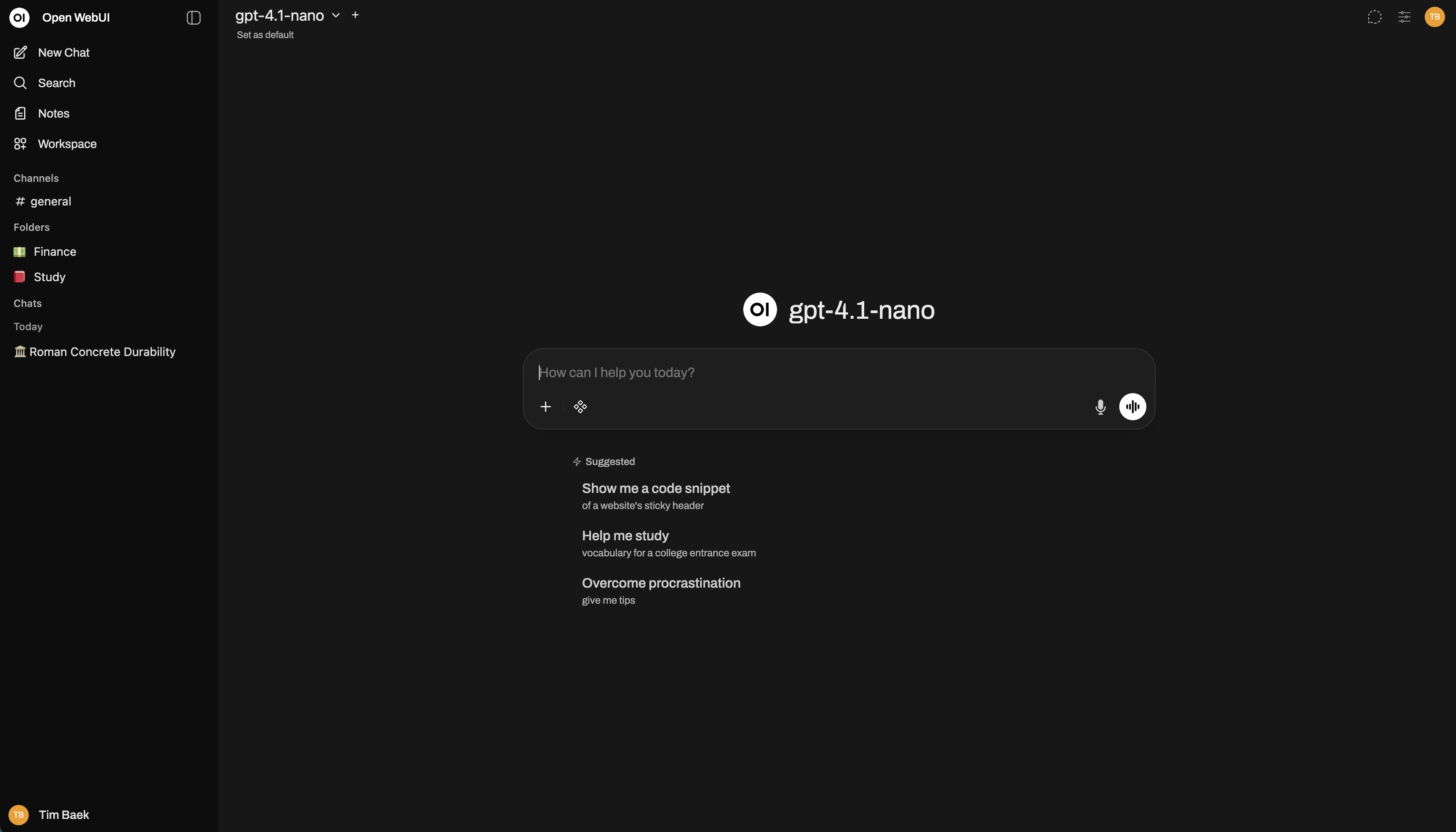

Open WebUI

Open WebUI (früher Ollama WebUI) ist eine selbstgehostete Web-Oberfläche für LLMs, die primär für die Integration mit Ollama entwickelt wurde, aber auch andere LLM-Provider wie OpenAI, Claude oder lokale Modelle unterstützt.

Hersteller & Lizenzmodell: Open WebUI ist ein Community-getriebenes Open-Source-Projekt unter MIT-Lizenz. Der Quellcode ist frei verfügbar auf GitHub.

Architektur & Einsatzszenarien: Die Plattform basiert auf einem modernen Stack mit Python (FastAPI) im Backend und Svelte im Frontend. Open WebUI kann als Docker-Container, via Kubernetes oder nativ installiert werden. Sie eignet sich besonders für Entwickler und Teams, die eine flexible, erweiterbare ChatGPT-ähnliche Oberfläche für lokale oder selbstgehostete Modelle benötigen.

Technologische Basis & Community: Mit über 45.000 GitHub Stars (Stand November 2025) verfügt Open WebUI über eine sehr aktive Community. Die Entwicklung schreitet schnell voran, mit regelmäßigen Updates und einem umfangreichen Plugin-System. Die Plattform unterstützt RAG, Dokumenten-Upload, Web-Suche und Multimodalität (Bild-Verarbeitung).

Hauptvorteile:

- Native Integration mit Ollama für lokale Modelle

- Umfangreiche RAG-Funktionalität mit Vektordatenbank-Unterstützung

- Plugin-System für Erweiterungen

- ChatGPT-ähnliche Benutzeroberfläche

- Aktive Entwickler-Community

Mögliche Einschränkungen:

- Primär für technisch versierte Nutzer konzipiert

- Installation kann ohne Docker-Kenntnisse komplex sein

- Weniger Business-Features wie Team-Management oder Rollen-Konzepte (im Vergleich zu Enterprise-Lösungen)

Mehr erfahren: Open WebUI Installation und Managed Hosting bei WZ-IT

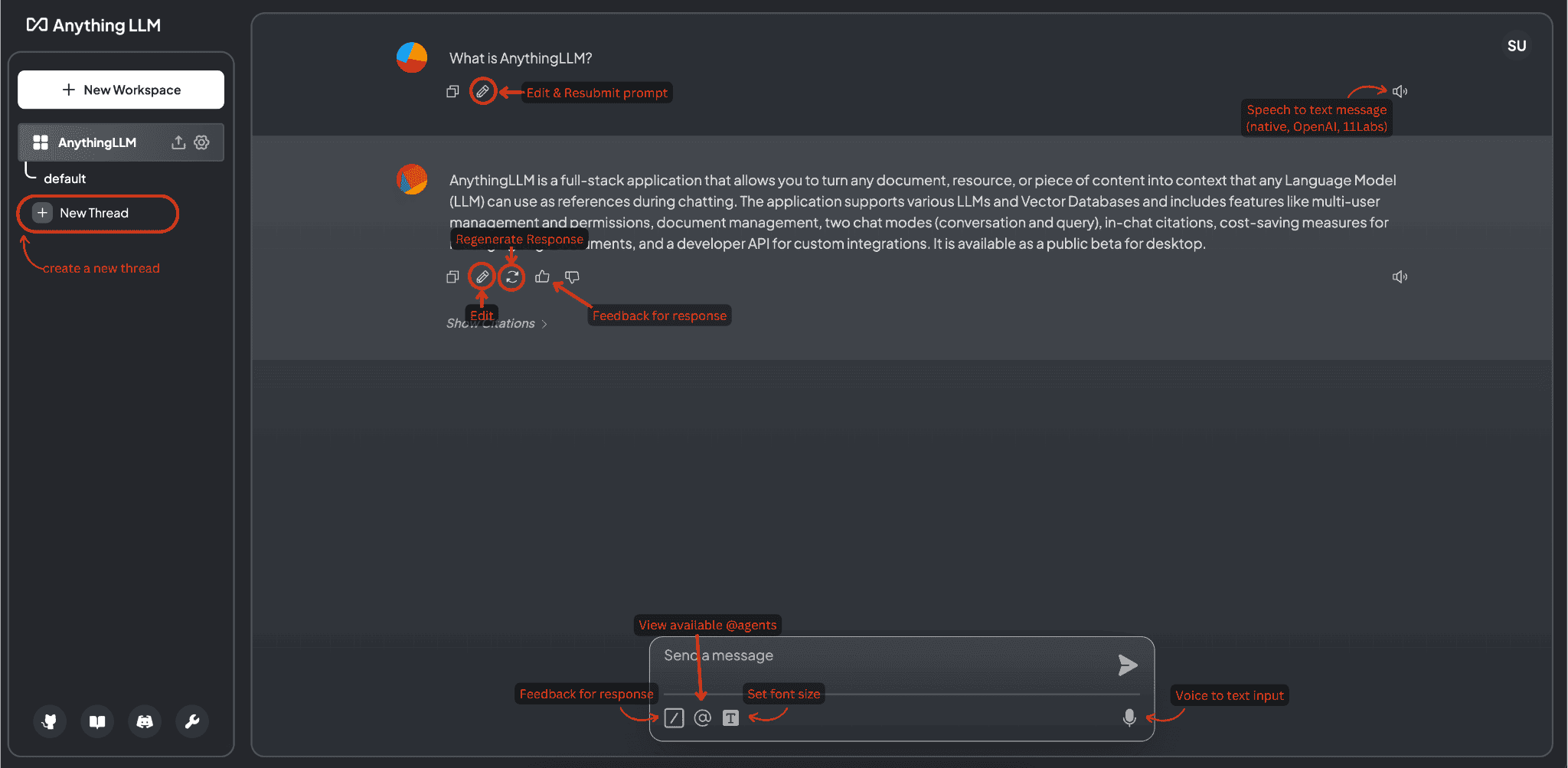

AnythingLLM

AnythingLLM positioniert sich als "All-in-One AI Desktop & Docker Lösung", die es ermöglicht, mit verschiedenen LLMs zu arbeiten, Dokumente zu verarbeiten und ein eigenes RAG-System aufzubauen – und das sowohl als Desktop-Anwendung als auch als Server-Installation.

Hersteller & Lizenzmodell: AnythingLLM wird von Mintplex Labs entwickelt und ist unter MIT-Lizenz verfügbar. Es ist auf GitHub als Open Source verfügbar.

Architektur & Einsatzszenarien: AnythingLLM bietet zwei Deployment-Modi: Als Desktop-Anwendung für Windows, macOS und Linux sowie als Docker-basierte Server-Installation. Der Stack basiert auf Node.js/Express im Backend und React im Frontend. Die Plattform zielt darauf ab, nicht nur Entwicklern, sondern auch Geschäftsanwendern einen einfachen Einstieg in selbstgehostete LLM-Nutzung zu ermöglichen.

Technologische Basis & Community: Mit über 25.000 GitHub Stars verfügt AnythingLLM über eine wachsende Community. Die Plattform legt besonderen Wert auf Benutzerfreundlichkeit und Business-Funktionen wie Workspace-Management, Team-Kollaboration und granulare Zugriffskontrolle.

Hauptvorteile:

- Desktop-Version für einfachen Einstieg ohne Server-Setup

- Umfassendes Workspace-Management für Teams

- Integrierte Vektordatenbank-Unterstützung (Pinecone, Chroma, Weaviate, etc.)

- Business-orientierte Features (Rollen, Permissions, API-Keys)

- Einfache Dokumenten-Verwaltung mit Drag & Drop

Mögliche Einschränkungen:

- Kleinere Community als Open WebUI

- Desktop-Version limitiert auf lokale Nutzung (kein Team-Sharing)

- Weniger Plugin-Ökosystem im Vergleich zu Open WebUI

Mehr erfahren: AnythingLLM Installation und Managed Services bei WZ-IT

Vergleich der Kernkriterien

| Kriterium | Open WebUI | AnythingLLM |

|---|---|---|

| Lizenz | MIT (Open Source) | MIT (Open Source) |

| Primäre Zielgruppe | Entwickler, Self-Hoster, Ollama-Nutzer | Business-User, Teams, Unternehmen |

| Deployment | Docker, Kubernetes, Native Installation | Desktop-App + Docker/Server |

| LLM-Provider | Ollama, OpenAI, Claude, Mistral, Lokal | OpenAI, Claude, Ollama, Lokal, viele weitere |

| RAG-Fähigkeiten | Ja, mit ChromaDB, Qdrant, Milvus | Ja, mit Pinecone, Chroma, Weaviate, LanceDB |

| Dokumenten-Upload | Ja (PDF, TXT, DOCX, etc.) | Ja (PDF, TXT, DOCX, XLSX, CSV, etc.) |

| Web-Suche | Ja (über Plugins) | Ja (integriert) |

| Multi-User Support | Ja (mit Authentifizierung) | Ja (mit Workspaces & Rollen) |

| API-Zugriff | REST API | REST API + Entwickler-API |

| Plugins/Erweiterungen | Umfangreiches Plugin-System | Begrenzt, Fokus auf Core-Features |

| Workspace-Management | Basis-Funktionen | Erweitert (Teams, Projekte, Rollen) |

| Installation-Komplexität | Mittel (Docker-Kenntnisse empfohlen) | Niedrig (Desktop) / Mittel (Server) |

| Benutzeroberfläche | ChatGPT-ähnlich, entwicklerorientiert | Business-freundlich, intuitiv |

| DSGVO-Konformität | Ja (bei Self-Hosting) | Ja (bei Self-Hosting) |

| Community-Größe | Sehr groß (45k+ GitHub Stars) | Groß (25k+ GitHub Stars) |

| Kosten (Self-Hosted) | Kostenlos (nur Infrastruktur) | Kostenlos (nur Infrastruktur) |

Stärken & Schwächen im Einzelnen

Open WebUI

Stärken:

-

Native Ollama-Integration: Open WebUI wurde ursprünglich für Ollama entwickelt und bietet die beste Integration für lokale Modelle. Das Modell-Management, Updates und die Ausführung erfolgen nahtlos.

-

Umfangreiches Plugin-System: Die Plattform verfügt über ein wachsendes Ökosystem an Plugins, die Funktionen wie Web-Suche, Code-Ausführung, Bild-Generierung und mehr hinzufügen.

-

Aktive Entwicklung: Mit mehreren Updates pro Woche ist Open WebUI eine der am schnellsten entwickelten LLM-Interfaces. Neue Features wie Function Calling, Vision-Support und erweiterte RAG-Funktionen werden kontinuierlich hinzugefügt.

-

RAG-Flexibilität: Unterstützt verschiedene Vektordatenbanken (ChromaDB, Qdrant, Milvus) und bietet erweiterte Einstellungen für Chunking, Embedding-Modelle und Retrieval-Strategien.

-

Entwicklerfreundlich: Klare API-Dokumentation, einfache Integration in bestehende Workflows und umfangreiche Konfigurationsmöglichkeiten.

Schwächen:

-

Steile Lernkurve für Nicht-Entwickler: Die Installation und Konfiguration erfordert technisches Verständnis. Ohne Docker-Kenntnisse kann der Einstieg herausfordernd sein.

-

Begrenzte Business-Features: Team-Management, granulare Berechtigungen und Audit-Logs sind weniger ausgereift als bei Business-orientierten Lösungen.

-

Dokumentation: Obwohl umfangreich, ist die Dokumentation manchmal fragmentiert, und spezifische Use-Cases müssen oft in GitHub-Issues oder Community-Foren recherchiert werden.

-

Ressourcen-Intensität: Bei Verwendung lokaler Modelle mit RAG können die Hardware-Anforderungen (RAM, GPU) erheblich sein.

AnythingLLM

Stärken:

-

Desktop-Version: Die Desktop-App ermöglicht einen sofortigen Einstieg ohne Server-Setup. Ideal für Einzelnutzer oder erste Experimente mit selbstgehosteten LLMs.

-

Business-Features: Workspace-Management, Team-Kollaboration, Rollen-basierte Zugriffskontrolle und API-Key-Verwaltung machen AnythingLLM besonders für Unternehmenseinsätze geeignet.

-

Benutzerfreundlichkeit: Die Oberfläche ist intuitiv gestaltet und richtet sich explizit an Business-User. Dokumenten-Upload via Drag & Drop, einfache Workspace-Erstellung und klare Navigationsstruktur erleichtern die Nutzung.

-

Vielseitige LLM-Unterstützung: AnythingLLM unterstützt eine breite Palette an LLM-Providern out-of-the-box, von Cloud-APIs bis zu lokalen Modellen (Ollama, LM Studio, LocalAI).

-

Eingebaute Vektordatenbanken: Unterstützung für zahlreiche Vektordatenbanken, einschließlich Cloud-Lösungen (Pinecone) und Self-Hosted-Optionen (Chroma, Weaviate, LanceDB).

-

RAG-Optimierung: Erweiterte Einstellungen für RAG, einschließlich Dokument-Verarbeitung, automatischem Chunking und Embedding-Management.

Schwächen:

-

Kleinere Community: Im Vergleich zu Open WebUI ist die Community kleiner, was zu weniger Community-Plugins und langsamerer Feature-Entwicklung führen kann.

-

Begrenzte Erweiterbarkeit: Das Plugin-System ist weniger ausgereift. Anpassungen erfordern oft direkten Code-Zugriff.

-

Desktop vs. Server Split: Die Desktop-Version bietet nicht alle Features der Server-Version (z.B. Multi-User-Support), was zu Verwirrung führen kann.

-

Dokumentation für Fortgeschrittene: Während die Basis-Nutzung gut dokumentiert ist, fehlen teilweise Guides für fortgeschrittene Setups (z.B. Hochverfügbarkeit, komplexe RAG-Pipelines).

Passung für den Unternehmenseinsatz / Use-Case Empfehlungen

Wann Open WebUI wählen?

Open WebUI eignet sich besonders für:

-

Entwickler-Teams mit Ollama-Fokus: Wenn Sie primär lokale Modelle via Ollama nutzen möchten und eine ChatGPT-ähnliche Oberfläche benötigen.

-

Technisch versierte Organisationen: Teams mit DevOps-Ressourcen, die eine hochgradig anpassbare Lösung suchen und bereit sind, Zeit in Setup und Wartung zu investieren.

-

RAG-Heavy Workflows: Projekte, die komplexe RAG-Pipelines mit mehreren Vektordatenbanken, Custom-Embeddings und Fine-Tuning benötigen.

-

Plugin-getriebene Erweiterungen: Wenn Sie eine Plattform benötigen, die durch Plugins erweitert werden kann (z.B. Web-Scraping, Code-Execution, Custom-APIs).

-

Open-Source-First-Strategie: Unternehmen, die Open-Source-Lösungen bevorzugen und aktiv zur Community beitragen möchten.

Beispiel Use-Case: Ein Software-Entwicklungsteam möchte Code-Reviews mit einem lokal gehosteten Llama-3-Modell durchführen, das auf interne Coding-Standards trainiert wurde. Open WebUI mit RAG über die interne Code-Dokumentation bietet hier die nötige Flexibilität.

Wann AnythingLLM wählen?

AnythingLLM eignet sich besonders für:

-

Business-Teams ohne dedizierte DevOps: Organisationen, die eine benutzerfreundliche Lösung benötigen, die auch von nicht-technischen Mitarbeitern genutzt werden kann.

-

Multi-Workspace-Szenarien: Unternehmen mit verschiedenen Abteilungen oder Projekten, die isolierte Workspaces mit unterschiedlichen Dokumenten-Sets und Berechtigungen benötigen.

-

Schneller Einstieg: Wenn Sie mit der Desktop-Version experimentieren und später auf Server-Deployment migrieren möchten.

-

Hybrid Cloud + Lokal: Wenn Sie flexibel zwischen Cloud-LLMs (OpenAI, Claude) und lokalen Modellen wechseln möchten, ohne die Infrastruktur zu ändern.

-

Compliance-intensive Branchen: Branchen wie Gesundheitswesen, Finanzen oder Rechtsberatung, die granulare Zugriffskontrolle und Audit-Trails benötigen.

Beispiel Use-Case: Eine Anwaltskanzlei möchte interne Rechtsdokumente durchsuchbar machen und mit einem LLM Zusammenfassungen generieren. AnythingLLM ermöglicht es, verschiedene Mandanten-Workspaces zu erstellen, jeweils mit spezifischen Zugriffsrechten und Dokumenten-Sets.

Hybrid-Ansatz: Beide Tools kombinieren?

In manchen Szenarien kann es sinnvoll sein, beide Tools parallel einzusetzen:

- Open WebUI für Entwickler-Teams mit komplexen RAG-Anforderungen

- AnythingLLM für Business-User, die einfach Dokumente hochladen und abfragen möchten

Beide Plattformen können dieselben Backend-Dienste (z.B. Ollama, Vektordatenbanken) nutzen, was Ressourcen spart.

Empfehlungen & Fazit

Zusammenfassung

Sowohl Open WebUI als auch AnythingLLM sind ausgereifte Open-Source-Lösungen für selbstgehostete LLM-Interfaces. Die Wahl hängt primär von den Anforderungen und der technischen Expertise der Organisation ab:

Open WebUI: Beste Wahl für technisch versierte Teams, die maximale Flexibilität, umfangreiche RAG-Funktionen und ein Plugin-Ökosystem benötigen. Ideal für Entwickler-zentrierte Workflows und Ollama-Integration.

AnythingLLM: Beste Wahl für Business-orientierte Teams, die Benutzerfreundlichkeit, Workspace-Management und einen schnellen Einstieg (via Desktop-App) priorisieren. Ideal für Unternehmen mit Compliance-Anforderungen und Multi-Team-Strukturen.

Entscheidungsmatrix

| Anforderung | Empfehlung |

|---|---|

| Primär lokale Modelle (Ollama) | Open WebUI |

| Business-User ohne IT-Hintergrund | AnythingLLM |

| Komplexe RAG-Pipelines | Open WebUI |

| Multi-Workspace mit Rollen | AnythingLLM |

| Umfangreiches Plugin-System | Open WebUI |

| Schneller Einstieg (Desktop) | AnythingLLM |

| Aktive Community & Updates | Open WebUI |

| Audit-Trails & Compliance | AnythingLLM |

DSGVO & Datenschutz

Beide Lösungen ermöglichen vollständige Datenkontrolle bei Self-Hosting:

- Alle Daten bleiben in der eigenen Infrastruktur (EU-Rechenzentrum möglich)

- Keine Drittlandübermittlung nach Art. 44 DSGVO

- Volle Kontrolle über Verarbeitungsvorgänge und Aufbewahrungsfristen

- Keine Abhängigkeit von US-Cloud-Anbietern

Bei WZ-IT bieten wir Managed Hosting für beide Lösungen in deutschen Rechenzentren an, inklusive DSGVO-konformer Auftragsverarbeitung.

Kostenbetrachtung

Self-Hosting (beide Lösungen):

- Software: Kostenlos (Open Source)

- Infrastruktur: Abhängig von Hardware-Anforderungen (ca. 50-200 €/Monat für kleine bis mittlere Deployments)

- Wartung: Interne IT-Ressourcen oder Managed Service

Managed Service (WZ-IT):

- Installation, Updates, Monitoring und Support inklusive

- DSGVO-konforme Hosting-Infrastruktur in Deutschland

- Individuelles Branding und SSO-Integration möglich

- Preise auf Anfrage

Ausblick & weiterführende Themen

Die Entwicklung selbstgehosteter LLM-Interfaces schreitet rasant voran. Zukünftige Trends umfassen:

-

Verbesserte Multi-Modalität: Integration von Bild-, Audio- und Video-Verarbeitung in RAG-Pipelines

-

Agent-Frameworks: Beide Plattformen arbeiten an Agent-Funktionalität, die es LLMs ermöglicht, autonom Tools zu nutzen und komplexe Aufgaben zu automatisieren

-

Fine-Tuning-Integration: Einfachere Wege, eigene Modelle zu trainieren und zu deployen

-

Föderation & Team-Kollaboration: Bessere Features für verteilte Teams und organisationsübergreifende Zusammenarbeit

-

Erweiterte Security: Zero-Trust-Architekturen, Ende-zu-Ende-Verschlüsselung für besonders sensible Daten

Verwandte Artikel:

- Managed Service für Open-Source Software

- DSGVO-konforme KI-Inferenz mit GPU-Servern

- Geschäftsprozess-Automatisierung mit n8n und KI-Agents

Kontaktieren Sie uns

Möchten Sie Open WebUI oder AnythingLLM in Ihrem Unternehmen einsetzen? Benötigen Sie Unterstützung bei der Installation, Migration oder dem Betrieb?

WZ-IT bietet:

- Beratung zur Tool-Auswahl (Open WebUI vs. AnythingLLM)

- Installation und Konfiguration in Ihrer Infrastruktur (Hetzner, Proxmox, AWS)

- Managed Hosting in deutschen Rechenzentren

- SSO-Integration mit Keycloak oder Authentik (LDAP, SAML, OAuth)

- Custom-Entwicklung und Plugin-Erstellung

- Schulungen für Ihr Team

- 24/7 Monitoring mit Uptime Kuma und Grafana

📅 Buchen Sie Ihr kostenloses und unverbindliches Erstgespräch: Termin vereinbaren

📧 E-Mail: [email protected]

Wir freuen uns darauf, Sie bei Ihrer LLM-Strategie zu unterstützen!

Quellenverzeichnis

- Open WebUI – Offizielle Website

- Open WebUI – GitHub Repository

- Open WebUI – Dokumentation

- Open WebUI – Features Übersicht

- Introduction to OpenWebUI: Self-Hosted Web Interface for LLM

- AnythingLLM – Offizielle Website

- AnythingLLM – GitHub Repository

- AnythingLLM – Desktop Version

- AnythingLLM – Dokumentation

- Exploring AnythingLLM: The All-in-One Easy AI Platform

Geschrieben von

Timo Wevelsiep

Co-Founder & CEO

Co-Founder von WZ-IT. Spezialisiert auf Cloud-Infrastruktur, Open-Source-Plattformen und Managed Services für KMUs und Enterprise-Kunden weltweit.

LinkedInLassen Sie uns über Ihre Idee sprechen

Ob konkrete IT-Herausforderung oder einfach eine Idee – wir freuen uns auf den Austausch. In einem kurzen Gespräch prüfen wir gemeinsam, ob und wie Ihr Projekt zu WZ-IT passt.

Timo Wevelsiep & Robin Zins

Geschäftsführer