Proxmox auf Hetzner in 5 Minuten: ZFS RAID1 Single-Node Setup mit Auto-Install Script

Proxmox auf Hetzner professionell betreiben? WZ-IT übernimmt Setup, Netzwerk-Design, Betrieb und Support für Ihre Proxmox-Infrastruktur. Zur Service-Seite →

Dieser Beitrag zeigt eine schnelle, reproduzierbare Installation von Proxmox VE auf einem Hetzner Dedicated Server als Single Node mit ZFS Mirror (RAID1) – ohne KVM-Konsole, indem der Server im Rescue System gebootet und ein Script die Installation automatisiert. Als Beispiel dient ein Setup, das in der Praxis gut zu einem Hetzner AX41-NVMe passt.

Was du am Ende bekommst

- Proxmox VE frisch installiert (automatisiert über ISO + Auto-Install)

- Root-Filesystem auf ZFS (Mirror/RAID1)

- Netzwerk in Proxmox typisch aufgebaut:

- vmbr0 = Public Bridge (IPv4/IPv6)

- vmbr1 = private Bridge mit NAT/Masquerading (praktisch für interne Netze/LXCs/VMs)

- Proxmox Web-GUI erreichbar über

https://<IP>:8006

Wichtige Hinweise (bitte lesen)

- Achtung: Datenverlust. Die Installation ist für eine Neuinstallation gedacht und überschreibt das System auf den Disks (typisches Reinstall-Verhalten).

- Es ist ein Third-Party Script (ariadata/proxmox-hetzner). Lies es vor dem Ausführen kurz durch und nutze es nur, wenn du damit einverstanden bist, dass es System- und Netzwerkdateien sowie APT-Quellen anpasst.

- Bei Hetzner ist die Netzwerkkonfiguration teilweise "speziell" (Routing/Gateway-Vorgaben). Wenn du später etwas änderst, orientiere dich an Hetzner-Guidelines.

Voraussetzungen

- Hetzner Dedicated Server (Beispiel: AX41-NVMe)

- Zugriff auf Hetzner Robot (oder Hetzner Cloud Rescue, je nach Produkt)

- SSH-Client (Linux/macOS Terminal oder Windows PowerShell/WSL)

- Optional: SSH-Key im Robot hinterlegt (bequemer im Rescue)

Inhaltsverzeichnis

- Schritt 1: Rescue System aktivieren

- Schritt 2: Installation per Script

- Schritt 3: Was das Script macht

- Schritt 4: Reboot & Login

- Quick Checks nach dem Login

- Quellen

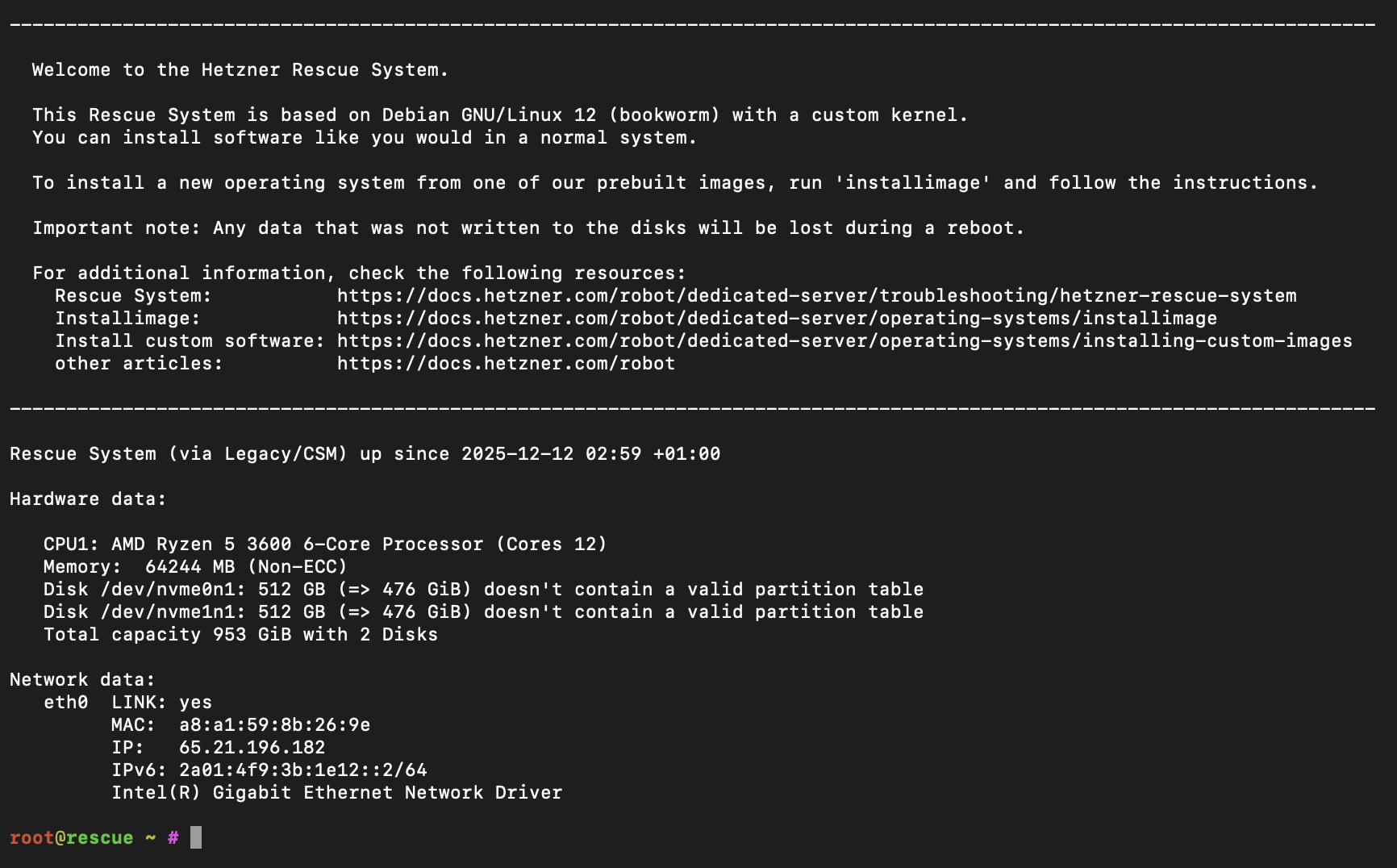

Schritt 1: Rescue System aktivieren (Hetzner Robot)

- Im Hetzner Robot: Servers → deinen Server auswählen → Rescue

- Linux / 64-bit auswählen (Public Key optional) und Rescue aktivieren

- Danach im Tab Reset einen Hardware Reset auslösen

- Per SSH als

rootins Rescue System einloggen (Passwort steht im Robot)

Schritt 2: Installation per Script starten

Im Rescue System als root:

bash <(curl -sSL https://github.com/ariadata/proxmox-hetzner/raw/main/scripts/pve-install.sh)

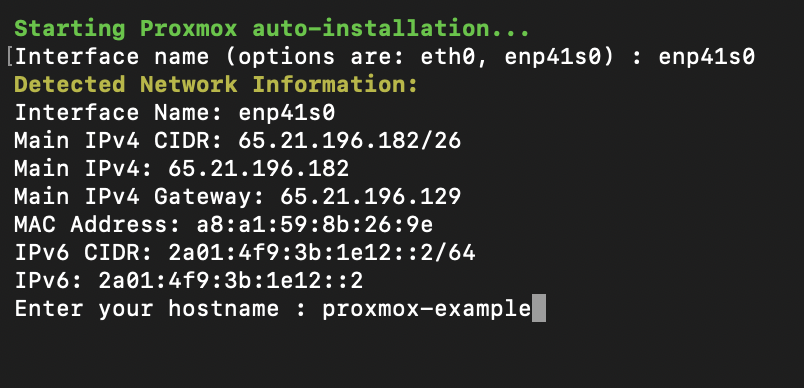

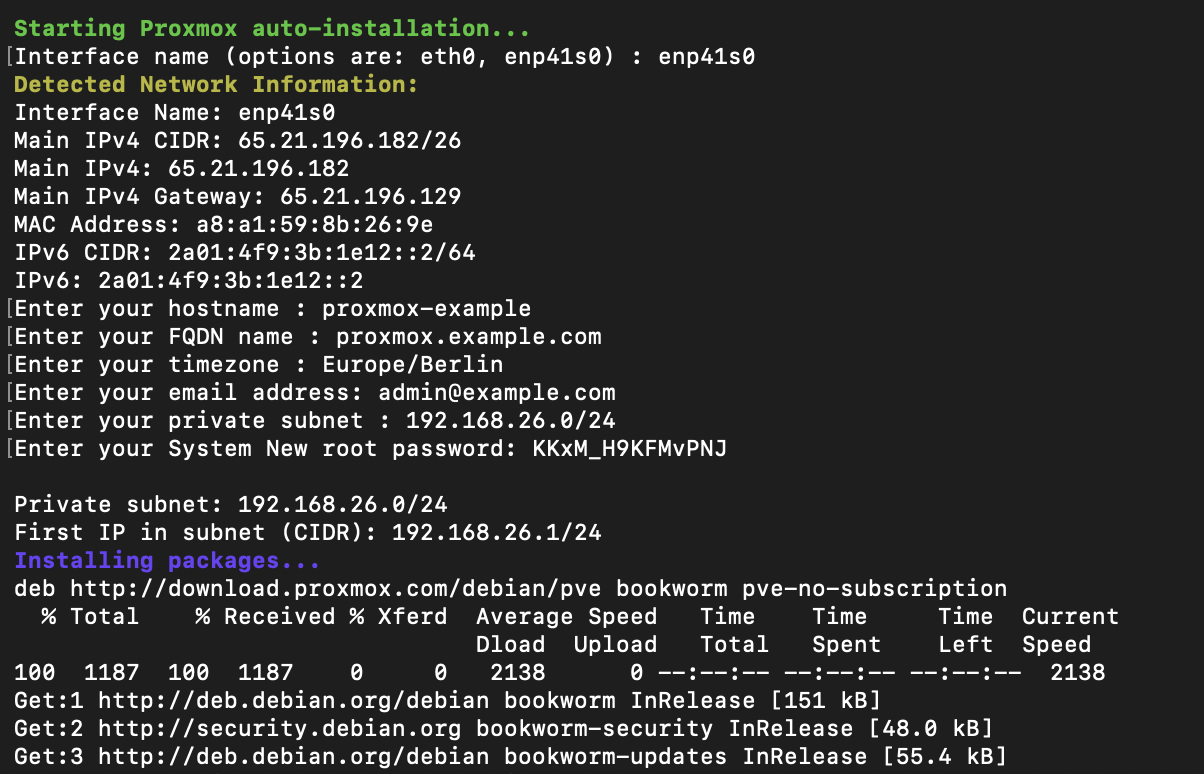

Das Projekt beschreibt den Ablauf als automatisierte Installation ohne Konsole (ISO wird geladen, Auto-Install Konfiguration erzeugt, ZFS RAID1 eingerichtet, Netzwerk IPv4/IPv6 gesetzt, Hostname/FQDN etc.).

Was das Script interaktiv abfragt:

- Netzwerk-Interface (z.B.

eno1) - Hostname & FQDN

- Zeitzone & E-Mail

- Private Subnet (für vmbr1/NAT)

- Neues root-Passwort

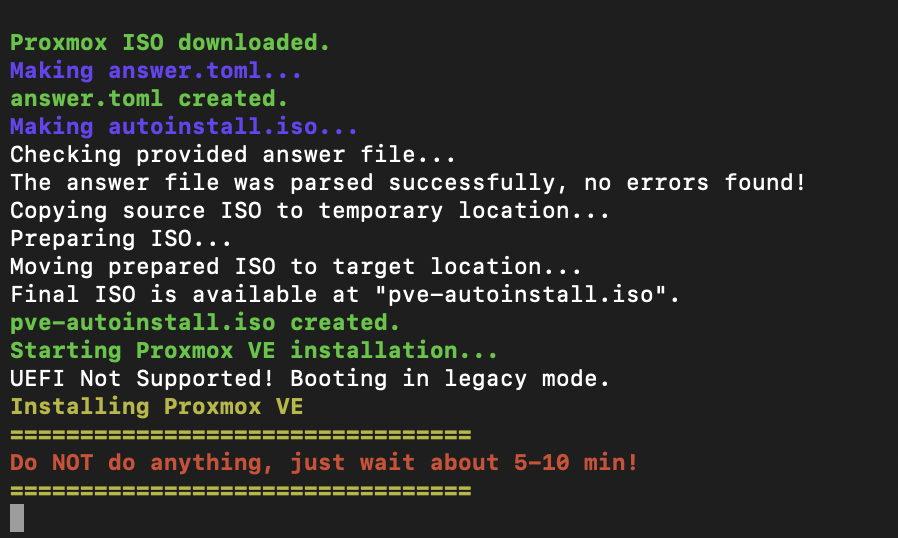

Nach Bestätigung startet die automatische Installation:

Schritt 3: Was das Script technisch macht (kurz & transparent)

Damit du später weißt, was da passiert, hier die wichtigsten Bausteine:

1) Proxmox ISO + Auto-Install

Das Script lädt eine Proxmox VE ISO (automatisch "latest") und erstellt eine Auto-Install ISO über den Proxmox Auto-Install Assistenten.

2) ZFS Mirror (RAID1)

Die Auto-Install Antwortdatei setzt:

filesystem = "zfs"zfs.raid = "raid1"- Installation auf zwei Disks (im Installer als

vda/vdb)

Proxmox unterstützt ZFS als Root-Option seit Jahren integriert (ohne manuelles Modul-Bauen).

3) Installation via QEMU im Rescue

Die Proxmox-Installation wird im Rescue System in einer QEMU-VM gebootet, die direkt auf die Server-Disks installiert (virtuell als vda/vdb gemappt).

4) Netzwerksetup in Proxmox (vmbr0/vmbr1)

Nach der Installation bootet das Script die frisch installierte Umgebung kurz mit SSH-Port-Forwarding, kopiert vorbereitete Template-Dateien rüber und setzt u.a.:

/etc/network/interfacesmitvmbr0(Public Bridge, IPv4 + IPv6)vmbr1(Private Bridge) plus NAT/MASQUERADE iptables-Regeln

- IP Forwarding via sysctl (

net.ipv4.ip_forward=1,net.ipv6.conf.all.forwarding=1)

Das ist praktisch, wenn du VMs/LXCs erstmal "intern" betreiben willst, ohne sofort Public IPs zu routen.

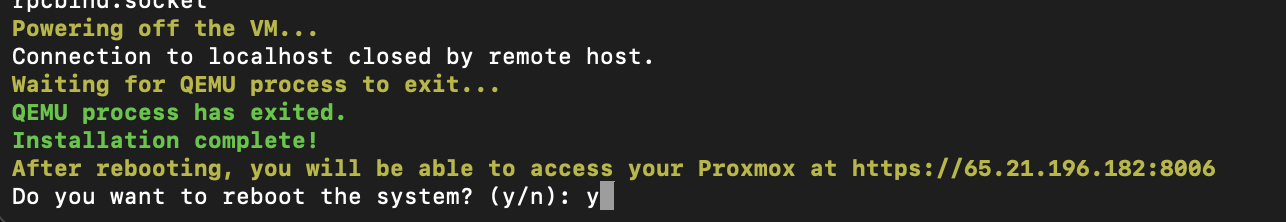

Schritt 4: Reboot – und Einloggen in Proxmox

Nach Abschluss fragt das Script, ob es rebooten soll:

Danach bootet dein Server ins installierte Proxmox.

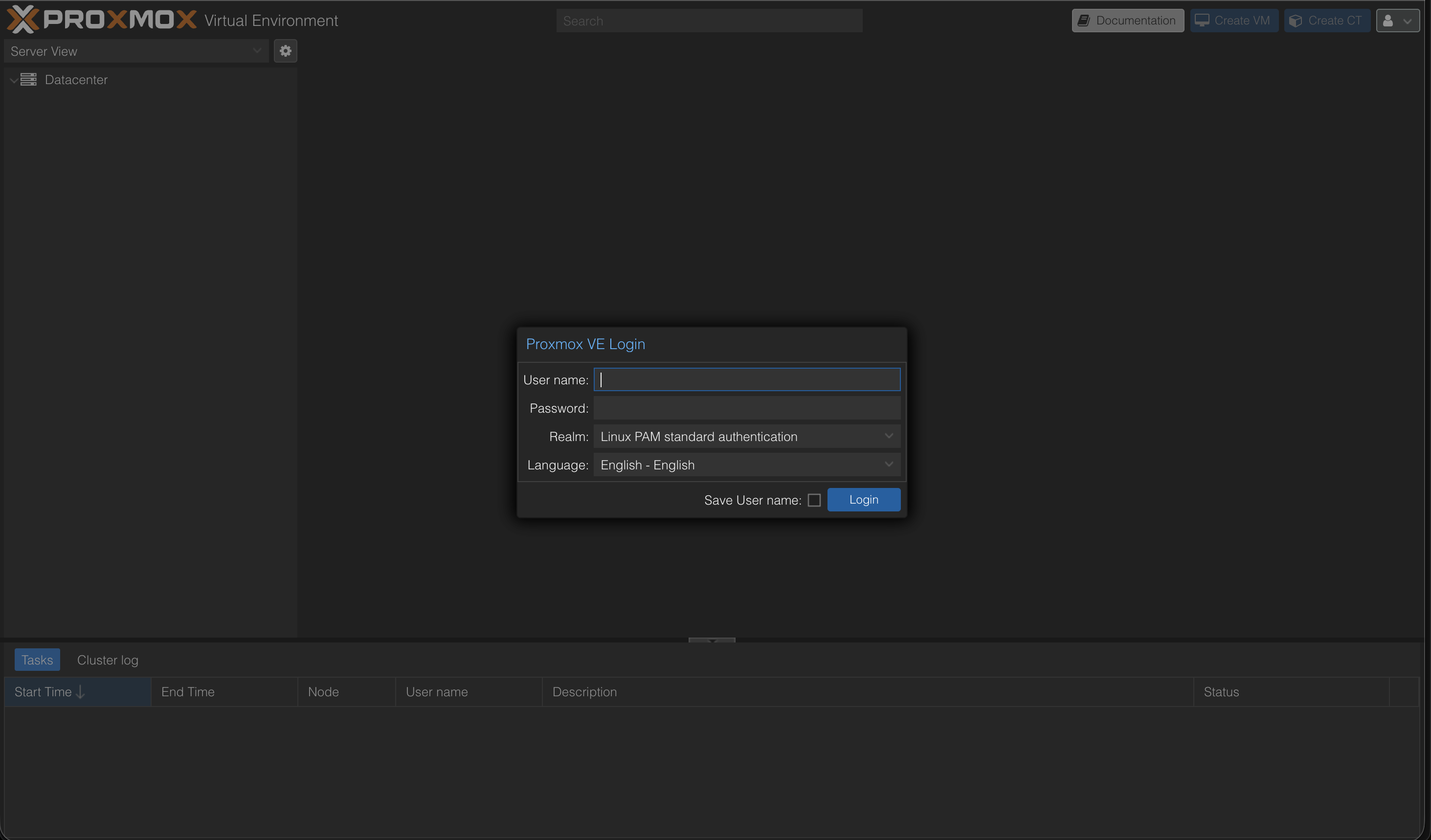

Die Web-Oberfläche erreichst du unter:

https://<deine-server-ip>:8006

Login:

- User:

root - Passwort: das von dir gesetzte Passwort (im Script/Installer)

Quick Checks nach dem Login

1. ZFS Pool prüfen (Shell im Node)

zpool status

zfs list

Du solltest einen Mirror-Pool sehen (ZFS RAID1). Das ZFS-Root-Setup ist der Kernpunkt des Ansatzes.

2. Netzwerk Bridges prüfen

Datacenter → <Node> → System → Network

Du solltest vmbr0 und vmbr1 sehen (Public/Private).

Optional: Nächste Schritte

- System aktualisieren:

apt update && apt dist-upgrade -y - ISO-Index aktualisieren und Templates laden

- Subscription-Warnung entfernen: Tutorial: Proxmox Subscription Notice entfernen

- Wenn du Hetzner-spezifische Netzwerkdetails manuell anpassen willst (zusätzliche IPs/Subnetze/Routing): Hetzner Community-Tutorials sind dafür eine gute Referenz.

Quellen

- Hetzner Doku: Rescue System

- Hetzner Community: Proxmox installieren & Netzwerk

- Proxmox Doku: Web GUI

- Proxmox Wiki: ZFS on Linux

- GitHub: ariadata/proxmox-hetzner

Weiterführende Guides

- Proxmox auf Hetzner – Managed Service

- Proxmox Übersicht

- Proxmox Wartung & Support

- Proxmox Backup Server

- Hetzner Expertise

- Proxmox Cluster Netzwerk auf Hetzner

Haben Sie Fragen zu Proxmox, Virtualisierung oder Cluster-Setups auf Hetzner? Wir unterstützen Sie bei Installation, Betrieb und Optimierung. Jetzt Beratungsgespräch vereinbaren

Häufig gestellte Fragen

Antworten auf wichtige Fragen zu diesem Thema

Über das Hetzner Rescue System per SSH: Rescue aktivieren, Server neu starten, ein Install-Script ausführen – der Rest läuft automatisiert.

Ja – genau dafür ist der Beitrag aufgebaut (AX41-NVMe als Beispiel, Single Node).

Es erstellt eine automatische Proxmox-Installation, richtet ZFS als Root-Dateisystem im Mirror ein und setzt Netzwerk/Hostname/FQDN.

Ja. Die Installation überschreibt die Systemplatten. Vorher unbedingt Backups ziehen.

Ein ZFS Mirror entspricht RAID1: Daten liegen gespiegelt auf zwei Datenträgern. Fällt eine SSD aus, läuft das System weiter.

Du bekommst ein minimales Live-System, von dem aus du die Installation komplett remote starten kannst – ohne physische Konsole.

Per HTTPS im Browser (Port 8006). Login: root + das gesetzte Root-Passwort.

vmbr0 ist die Public Bridge (öffentliche IP), vmbr1 ein internes privates Bridge-Netz für VMs/Container mit NAT.

Ja, wenn vmbr1 als privates Netz mit NAT eingerichtet ist. Der Host macht Masquerading nach außen.

Mindestens SSH (22) und Proxmox Web (8006). Empfehlung: so wenig wie möglich offen, Rest per Firewall/VPN absichern.

Für Produktion empfehlenswert (Support + Enterprise-Repo). Für Tests/Homelab geht's ohne – dann No-Subscription-Repo nutzen.

Auf der Shell: zpool status ausführen. Du solltest einen Mirror-vdev sehen und beide Devices als ONLINE.

Ja – für viele Workloads reicht ein einzelner Host. Für High Availability brauchst du mehrere Nodes + Quorum-Setup.

Lassen Sie uns über Ihre Idee sprechen

Ob konkrete IT-Herausforderung oder einfach eine Idee – wir freuen uns auf den Austausch. In einem kurzen Gespräch prüfen wir gemeinsam, ob und wie Ihr Projekt zu WZ-IT passt.

Timo Wevelsiep & Robin Zins

Geschäftsführer